CHAPTER 8 변동성 돌파 전략과 자동매매

이번 장은 크레온 플러스 API를 사용하기 위하여 계좌를 개설하고 pywin32를 라이브러리를 이용하여 크레온 API에서 제공하는 COM 오브젝트를 사용하는 방법에 목적을 두고 진행했다. 개인적으로 etf는...... 관심이 없다.

파이썬 64bit 개발환경이라 COM 오브젝트를 이용하기 위해서 파이썬 32bit를 사용해야 한다. 예전에 파이썬 32bit 가상환경을 설정해 놨는데, 뭔가 잘못되어 idle도 vscode도 32bit를 사용할 수 없게 되었다. 거기에 powerShell에서 conda 명령어도 사용할 수 없다. 그래서 이것부터 해결했다.

anaconda를 이용하여 파이썬 32bit 설치하기

set CONDA_FORCE_32BIT=1

conda create -n py38_32 python=3.8 anaconda간단하게 파이썬 32비트 설치 했다.

powerShell에서 conda 명령어 사용하기

conda init powershell

conda config --set auto_activate_base false이렇게 하면 간단하게 해결! vscode에서도 편안하게 파이썬 32bit 인터프렌터로 설정만 하면 끝이다.

8.1 래리 윌리엄스의 변동성 돌파 전략

8.1.1 변동성 돌파 전략

8.2 크레온 플러스 API

8.2.1 크레온 로그인 ....

8.2.2 크레온 플러스 자동 접속

8.2.3 크레온 시스템 접속 체크

8.2.4 크레온 데이터 조회

8.2.5 로그 메시지 출력

8.3 주가 및 계좌 정보 조회

8.3.1 현재가 조회

8.3.2 OHLC 조회

8.3.3 주식 잔고 조회

8.3.4 주문 가능 금액 조회

8.4 ETF 매수/매도

8.4.1 네이버 ETF 정보 스크레이핑

8.4.2 매수 목표가 계산

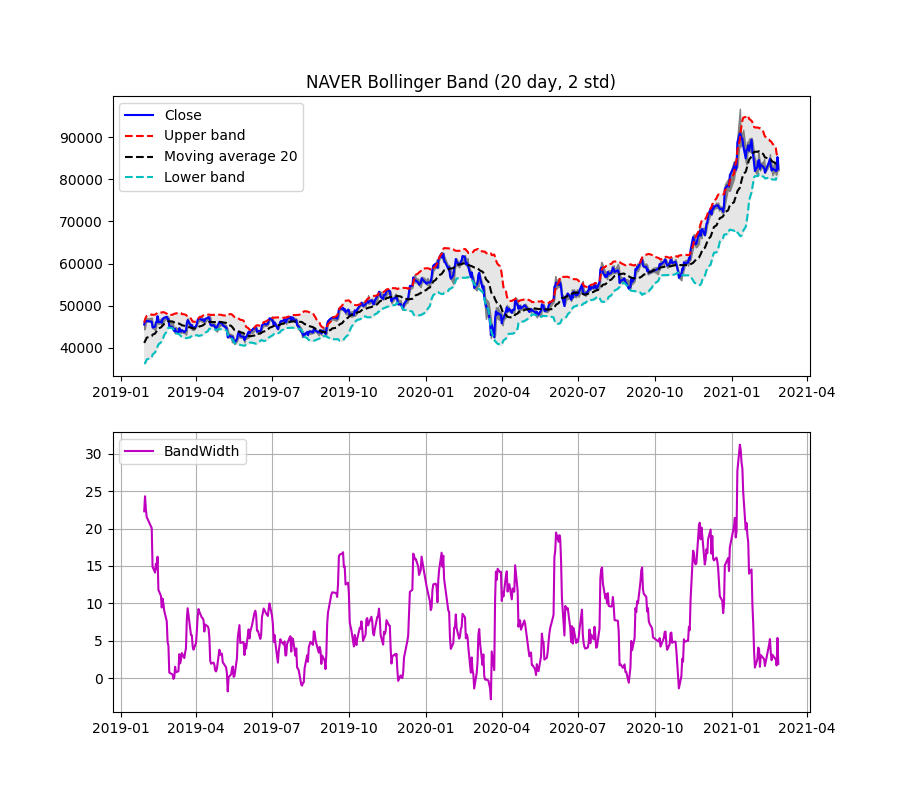

8.4.3 이동평균값 조회

8.4.4 주식 매매 주문 방식

8.4.5 최유리 FOK 매주 주문

8.4.6 최유리 IOC 매도 주문

8.5 메인 로직과 작업 스케줄러 등록

8.5.1 메인 로직과 시간대별 처리

8.5.2 작업 스케줄러 등록

8.5.3 전체 코드 및 실행 결과

8.6 핵심 요약

이전글 - 2021.03.24 - [책들] - [파이썬 증권 데이터 분석] 7 장고 웹 서버 구축 및 자동화 320 ~ 367p

[파이썬 증권 데이터 분석] 7 장고 웹 서버 구축 및 자동화 320 ~ 367p

7 장고 웹 서버 구축 및 자동화 패키지 업데이트로 사용방법이 조금씩 달라져서 이번 장은 따라만 하면 안된다. 예전에 플라스크로 웹페이지에 'Hello World'만 출력해 본 기억이 난다. 그래서 M

bonghanwith.tistory.com

- 마지막 -

'책들' 카테고리의 다른 글

| [도서체험단] 한권으로 끝내는 스마트폰 사진강의 채수창 앤써북 (2) | 2021.06.04 |

|---|---|

| [책] 그림으로 배우는 C Programming Basic (1) | 2021.06.02 |

| [도서체험단] 상세페이지 제작 [개정 4판] 김대용, 김덕주 (0) | 2021.04.19 |

| [책] 몸은 기억한다 - 베셀 반 데어 콜크 (0) | 2021.04.11 |

| [도서체험단] 나는 직장인 N잡러 돈 걱정 없이 산다! (0) | 2021.03.29 |